電腦如何學會看懂眼前的場景?能夠辨別物體也知道輪廓!

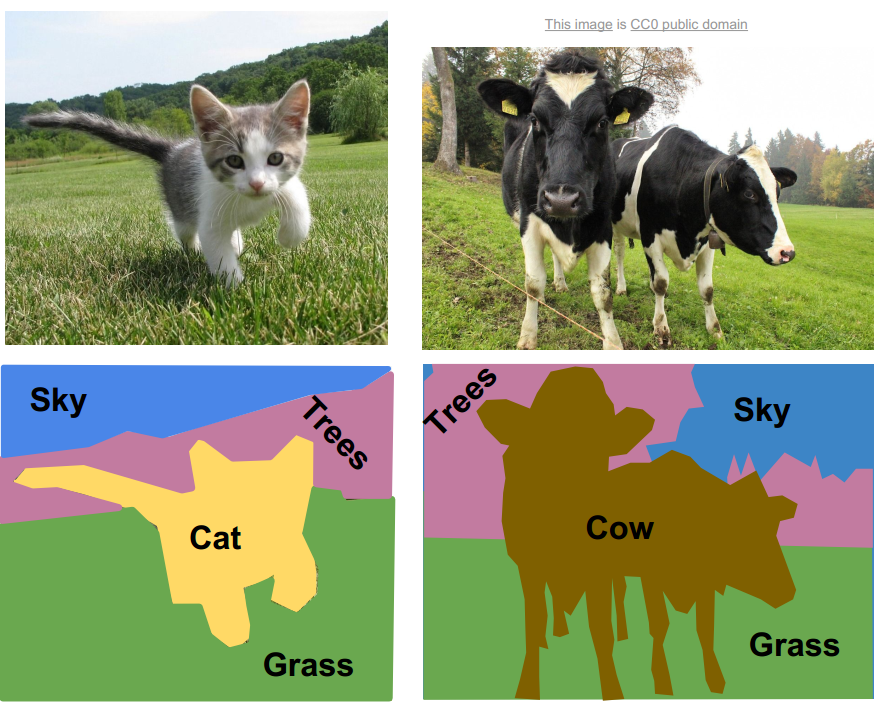

電腦視覺應用於許多生活場景,舉例:自駕車、醫療影像、瑕疵偵測等等。但電腦如何了解一張圖片或影片中有什麼物體或是物體的位置,就需要大量的人工標記答案進行訓練模型(圖1)。訓練好的模型就能快速的進行推理,做到彷彿人類判別視野中的物體以及位置。

|

| 圖1. 上方為原始圖片,下方是人工標記的類別以及該類別的區域。 |

借助全連結卷積神經網路,模型透過卷積將影像尺寸縮小,並能接受各種尺寸的輸入影像。模型將透過訓練嘗試了解每一個Pixel的類別。FCN的隱藏層都是卷積層,並在最後一層輸出層透過Upsampling放大尺寸至與輸入影像相同。輸出的預測圖與輸入圖像尺寸相同,所以可以知道每一個Pixel屬於哪一個物體的標籤,也就能知道該物體的範圍與邊界(圖2)。

|

| 圖2. Fully Convolutional Network(FCN)模型構造 |

從圖3可以發現FCN所預測的結果,物體的範圍以及邊界較為正確。從表1可以看到FCN-8s的mean IU分數最高且推理速度最快,大約花費175ms。

|

| 圖3. 左至右為 FCN預測答案、SDS預測答案(另一種演算法)、正確答案(來自人工標記)、輸入模型之原始圖片 |

|

| 表1. R-CNN, SDS, FCN-8s三種模型使用VOC2011, VOC2012資料集的預測表現 |

Semantic Segmentation(語義分割)在推理、預測的速度提升,更能夠融入生活場景。期望未來電腦視覺的發展,能夠幫助人類執行任務上提高效率,並減少時間成本。

撰文:許楷翊

參考文獻:

Long, J., Shelhamer, E., & Darrell, T. (2015). Fully convolutional networks for semantic segmentation. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 3431-3440).

留言

張貼留言