神經網路的運算威力

仿神經運算最近幾年因為相關硬體的崛起而變得受歡迎,一種新型態的算法也正在應運而生。自然演算法(natural algorithm)其中一個分支,正試圖將資工的演算邏輯與生物數學模型相結合;脈衝神經網路(SNN)的數學模型自然也被視為研究主題之一。

想像我們要求解一個最小平方問題 |Ax-b|2。如果我們把A作為網路的權重矩陣,b作為神經元的電流輸入,對這個網路模擬一段時間,最後得到的脈衝頻率竟然就是我們要求解的答案x!這究竟是一個巧合,或者背後的確有理論基礎?

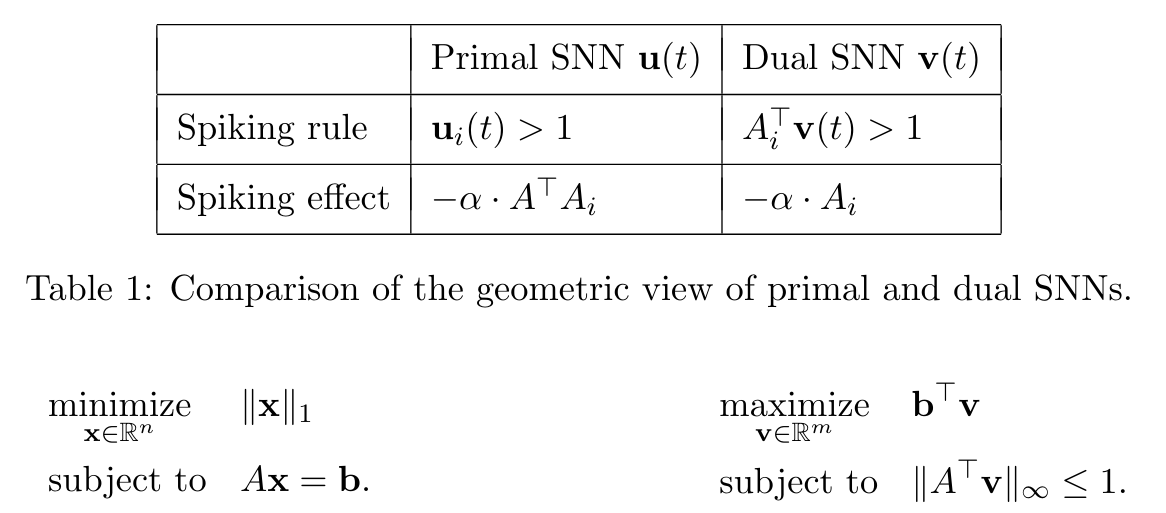

一篇中研院的研究表明(Chou, Chung, and Lu 2018)這的確是可行的,同時不僅試圖從幾何角度建立概念,也提供了相關證明。首先,針對原有(primal)的權重矩陣與電流輸入,我們都能得到一個對應的對偶(dual)版本,是為最佳化問題的對偶性。

|

| 表一:原始/對偶SNN之間的關係。其中u(t), v(t)為神經膜電位,A為神經權重C的科列斯基分解矩陣C=ATA,α為狄拉克δ函數(作為神經脈衝)的乘法器,決定脈衝的大小。 |

若將神經膜電位的狀態畫在一個平面上,就會發現電流輸入形成一股力道將狀態點向外推。我們恰巧可以透過連結與觸發電位的機制,形成最佳化問題中的約束。這些約束形成了一道道的「牆壁」,圍住了神經活動的範圍。

|

| 圖一:對偶版本網路的幾何表示。圖中A為神經權重C的科列斯基分解矩陣C=ATA, Ai為其行向量。 |

|

| 圖二:對偶版本網路的幾何表示(續)。圖中b與電流輸入I的關係為I=ATb。可看見電流輸入將神經活動「推向」外側。 |

當神經超過了「可行區域」(feasible region),動作電位就會觸發,使得對偶版本的網路回歸合理,並更新了原版本網路的神經放出頻率(也就是我們想求的答案)。我們也可以把這樣的一個過程視為一種梯度下降法。在持續了這樣的過程一段時間後,我們也得到了答案必定收斂的的證明。

註:關於最佳化問題的凸性與對偶性,建議可以觀看參考資料中的影片(Visually Explained 2021a) (Visually Explained 2021b) (Visually Explained 2021c)來得到一個明確的印象。

撰文:葉宸甫

參考資料

Chou, Chi-Ning, Kai-Min Chung, and Chi-Jen Lu. 2018. “On the Algorithmic Power of Spiking Neural Networks.” arXiv. http://arxiv.org/abs/1803.10375.

Visually Explained. 2021a. “What Is Mathematical Optimization?” https://www.youtube.com/watch?v=AM6BY4btj-M.

Visually Explained. 2021b. “Convexity and The Principle of Duality.” https://www.youtube.com/watch?v=d0CF3d5aEGc.

Visually Explained. 2021c. “The Karush–Kuhn–Tucker (KKT) Conditions and the Interior Point Method for Convex Optimization.” https://www.youtube.com/watch?v=uh1Dk68cfWs.

留言

張貼留言