看見像素的運動:單眼無人機如何靠「光流」穿越障礙叢林?

在密林之中,當無人機以每秒6公尺的速度穿越樹幹與細枝間的狹縫時,它如何判斷該左轉還是右閃?沒有雷達、也不靠立體鏡頭,僅用一台普通的單眼攝影機,它能安全飛行、甚至比人還靈活。來自上海交通大學的一項最新研究提出一種仿昆蟲視覺的創新方法,讓無人機透過「看」像素的運動,也就是光流(optical flow),來學會避開障礙、維持平衡,並完成高速飛行任務。在自主飛行領域,大多數無人機會仰賴雷射雷達或立體相機來建構環境的3D地圖,並規劃路徑。但這些感測器體積大、耗電高、價格不斐,對小型空中載具來說並不理想。

相對地,大自然中蒼蠅與蜜蜂等昆蟲靠一對單眼,就能完成快速閃避與飛行。這背後的關鍵正是「光流」:當一台攝影機移動時,畫面中的每個像素會隨環境中物體的遠近產生不同的移動速度與方向,這就是光流。就像開車時,旁邊的路燈飛快向後掠過、遠處的山頭幾乎不動,我們大腦就可感知速度與深度。

研究團隊設計了一套從頭學習的避障系統,不是靠傳統手工規則,而是讓無人機直接從光流學會怎麼飛。他們建構了一個端對端的學習架構,包含三個核心技術:

1. 光流注意力系統:他們發現,畫面中間的光流訊息最關鍵,將高解析光流的中央區域與整體低解析度光流結合,提升算法對重要區域的感知能力。就像人開車時眼睛專注看前方,無人機也能對畫面中央給予更高的關注權重。(圖一)

|

| 圖一、光流注意力系統:若畫面中央無空間可前進,則可透過轉向重新探索,結合注意與感知雙策略提升決策能力。 |

2. 主動感知策略:除了「看」,無人機還會調整自己的視角,把攝影機主動朝向前進方向,確保關鍵資訊在正中間。

3. 可微分物理模擬器:他們打造了一套能快速模擬飛行軌跡、光流與控制結果的模擬器,主要用來模擬無人機的動態與控制過程,使訓練過程可以直接進行「梯度下降」優化,快速收斂控制策略。(圖二)

實驗結果

研究團隊以NVIDIA RTX 3090 GPU訓練,2小時內完成。模型能成功閃避細如樹枝的障礙,最高達每秒6公尺的速度。(圖三)

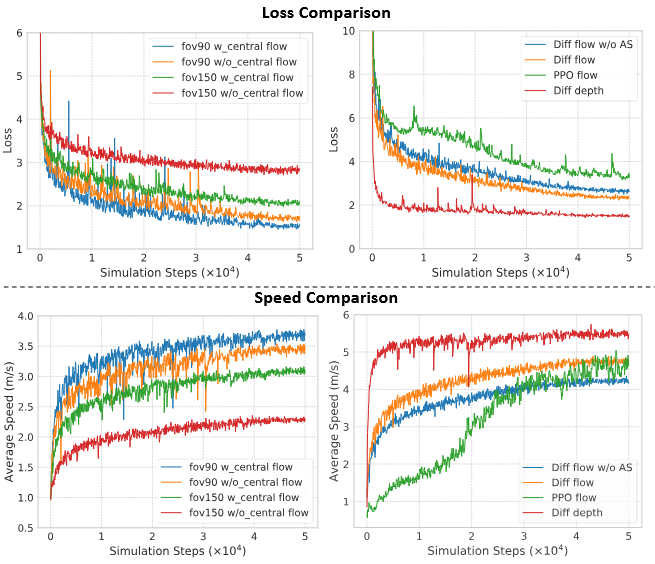

過去的訓練方式多半使用模仿學習或強化學習(如 PPO),這類方法常常收斂慢、效果不穩。該研究的可微模擬器能直接計算控制器的誤差與影響,像訓練神經網路一樣,讓飛行策略學得更快、更穩。(圖四)

|

| 圖四、訓練成效比較 左列圖:中央注意力策略提升大視角相機下的效能(150° FOV表現最佳)。 右列圖:不同方法比較: -- 光流 vs 深度:深度訓練收斂較快,但光流遷移能力更佳。 -- PPO vs 可微物理:可微模擬支援解析梯度,訓練更穩定、收斂更快。 -- 主動 vs 非主動感知:主動調整視角提升表現。 |

然而,光流並不是完美的方法。當相機快速旋轉時,像素的流動方向會類似「前方有障礙」,導致誤判。此外,畫面中「前進方向」的焦點位置(稱為 FoE)幾乎沒有光流,因此飛行方向最需要資訊時,反而是感知最弱的地方。這些問題,未來可以透過更精準的光流預測網路(如 NeuFlow)、加入 IMU 等感測器做多模態融合……等方法改善。

這篇研究不只證明「一顆攝影機」也能讓無人機敏捷飛行,也展示了生物啟發式視覺與機器學習結合的可能性。

撰文:余雪淩

原始論文:Y. Hu et al., "Seeing Through Pixel Motion: Learning Obstacle Avoidance From Optical Flow With One Camera," in IEEE Robotics and Automation Letters, 10(6), pp. 5871-5878, (2025)

留言

張貼留言