AI繪圖的背後底層程式介紹Diffusion-model

GAN!阿不是!我們不是要聊GAN,而是Diffusion model,AI繪圖的背後機制,最近AI繪圖這麼火熱,身為常常使用AI程式作為工具的實驗室也不能不跟風來聊聊這個東西啦~

Diffusion model是一個相比GAN更有效的生成模型,不同於 GAN 需要一個鑑別器來輔助訓練生成器,它本身就是一個可逆推網路,僅靠本身就可將真實樣本訓練網路將其分布轉換為高斯分布的Hidden Space,待網路訓練完成後僅需逆推網路就可以做為生成器使用,而Diffusion Model 的中心思想是使用若干個微幅轉換來轉換Hidden Space成為Sample Space,如圖(一)所解釋。而用於最近熱門軟體Stable Diffusion中的是被稱為「潛在擴散模型」(latent diffusion model; LDM)的變體,類似於以往介紹過的Autoencorder ,LDM訓練自編碼器將圖像轉換成低維度的環境,極大化有效降地計算成本,亦可使複雜性降低和細節保留之間達到接近最佳點,從而大大提高了視覺保真度。這也就是為何現在開發出來的Stable Diffusion具有高效能亦能在通用家機端使用而不需要過分要求的硬體效能,diffusion model可以參考引用[5]中的文章亦有更為詳細的數學講述,而latent diffusion model 更詳細的數學講解,非常推薦可以閱讀引用[2]的文章。

圖(一) 正向擴散模型示例 [1]

XT 代表抽樣自高斯分布Hidden Space的圖片,X0 代表抽樣自Sample Space的圖片,從 X0 到 XT 是模糊化的過程,中間經過若干事先定義好的操作q(Xt∣Xt−1),而生成模型旨於學習模糊化的逆向轉換 pθ(Xt−1∣Xt) ,當我們有了pθ(Xt−1∣Xt) 就可以隨機抽樣自Hidden Space並轉成一張合成的圖片。[1]

|

| 圖(一) |

|

| 圖(二) latent diffusion model 示意 [1] |

|

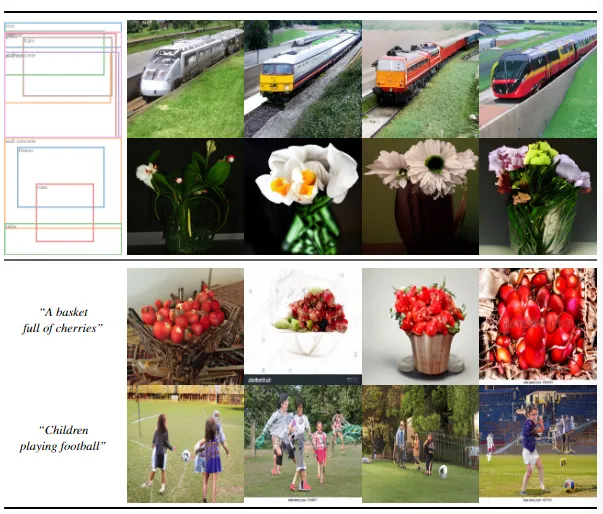

| 圖(三) 研究發表的latent diffusion model 順練完成後的模型的任務展示 [3] |

圖(四) 商業用Stable Diffusion 展示完整性高的程式可帶來的任務展現 [4]

給予不同的參數帶來的風格影響:

圖中第一行: art style of artgerm and greg rutkowski

圖中第二行: art style of makoto shinkai and akihiko yoshida and hidari and wlop

圖中第三行: art style of Michael Garmash

圖中第四行: Charlie Bowater and Lilia Alvarado and Sophie Gengembre Anderson and Franz Xaver Winterhalter, by Konstantin Razumov, by Jessica Rossier, by Albert Lynch

|

| 圖(四) |

撰文:徐楷昕

引用

[3] High-Resolution Image Synthesis with Latent Diffusion Models, Robin Rombach,Computer Vision and Pattern Recognition, 20 Dec 2021

留言

張貼留言