Mamba:序列模型的新星

最近,來自2023年的一篇突破性研究 "Mamba: Linear-Time Sequence Modeling with Selective State Spaces" 由Albert Gu和Tri Dao發表,為我們帶來了一種全新的序列模型架構,它名為Mamba。這一技術不僅提升了處理效率,還在多個領域展現了前所未有的效能。

如何解決傳統模型的效率問題?

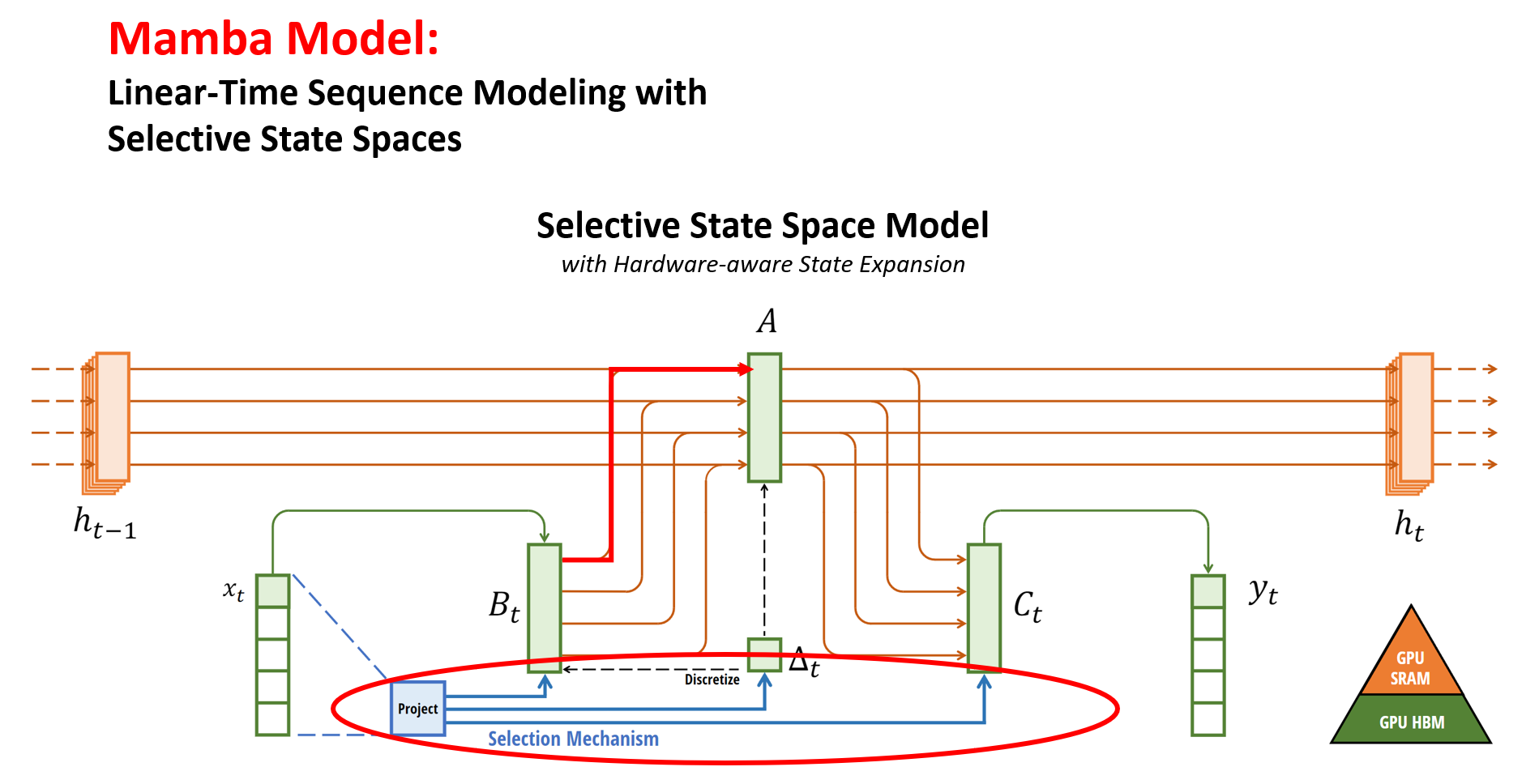

傳統的序列模型,如廣為人知的Transformer架構,雖然強大,卻在處理長序列時效率低下,白話來講就是當輸入的文章長度太長時,Transformer架構的LLM會運作非常緩慢,並且需要大量運算資源。Mamba模型通過引入一種新穎的“選擇性狀態空間模型”(Selective State Spaces, SSMs)來解決這一問題。這種模型使得處理效率和模型性能在不同長度的序列中都得到了顯著提升。(Fig 1.)

|

| Fig 1. 透過Selection Mechanism 可以透過輸入的文字去控制中間的矩陣,進而達到Attention機制 |

Mamba的一大創新之處在於其模型設計。它允許SSM參數依賴於輸入數據,這意味著Mamba能夠根據序列的變化動態地調整處理方式。無論是語言、音頻還是基因組學的數據,Mamba都能夠高效地處理,靈活應對不同數據類型(Fig 2 &3.)

|

| Fig 2. 各種模型架構在文本長度固定時,相同的FLOPs(floating point operations)時,Mamba表現最好,勝過傳統Transformer非常多 |

|

| Fig 3. 在DNA modeling任務中,當參數量固定時,Mamba也是表現最佳的模型 |

在實際數據集上的驗證結果顯示,Mamba在語言模型中的表現尤其出色,無論是在模型規模還是效率方面都超越了傳統的Transformer模型。這證明了Mamba不僅在理論上前瞻,實際應用中也能發揮巨大的效能。

Mamba不僅為序列模型的發展提供了新的方向,也為各類人工智慧應用開辟了新的可能性。總之,Mamba模型代表著AI領域一次重要的飛躍,將序列模型的處理效率和效能推向了新的高度。

P.S.特別感謝 #ChatGPT 潤飾此篇文章。 🤖

撰文:許楷翊

參考文獻:

Gu, Albert, and Tri Dao. "Mamba: Linear-time sequence modeling with selective state spaces." arXiv preprint arXiv:2312.00752 (2023).

留言

張貼留言