Meta(Facebook)推出的對話式圖像分割技術,能讓你辨識圖片中任何東西!

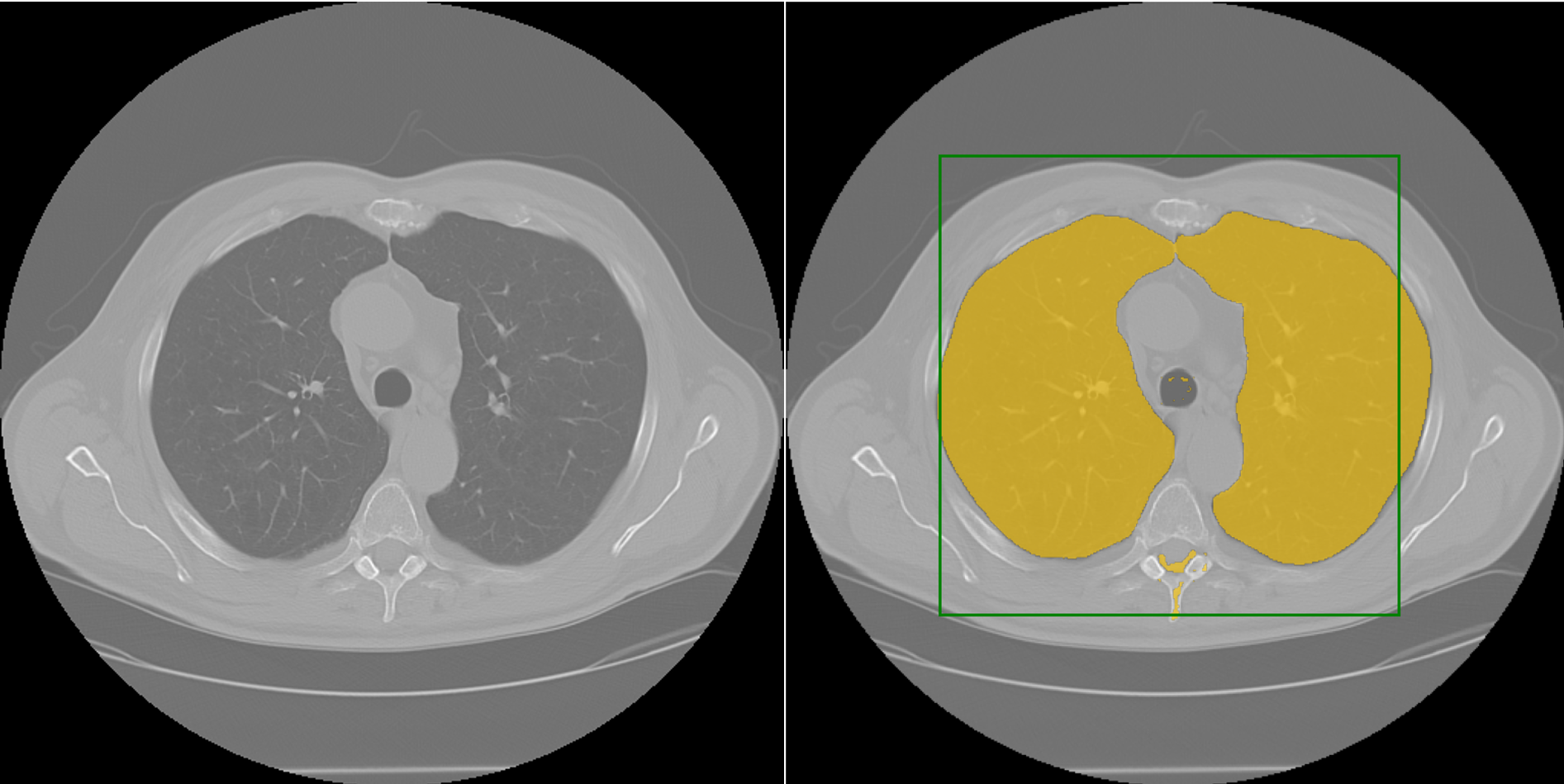

在現代科技的推動下,人工智慧的應用越來越廣泛,其中的電腦視覺技術在圖像辨識、目標檢測、圖像生成等方面擁有極高的研究價值和應用價值。然而圖像分割一直是電腦視覺領域中的關鍵問題之一,它旨在從一張圖片中找到不同的物體,將其分成不同的區域,是許多應用的基礎,例如: 常常在醫學、自動駕駛使用。比如在醫學領域,醫生需要麻煩手動勾選出CT掃描檢視上的腫瘤。而 Segment Anything Model(SAM) 則無需人工勾選,只需要圖片上手點出一個點做提示,就能精確分割出目標物體。(圖1)

然而,現有的圖像分割模型存在著許多限制,需要龐大的標註數據和龐大的模型參數,而且無法應對不同的圖像分割任務。為了解決這些限制,Meta(FaceBook)在此背景下提出了Segment Anything Model(SAM)模型。SAM模型可通過對話式的方式(給予模型提示)來分割圖像,通過自然語言提示(prompt)來辨識圖像中的物體或區域,不僅能夠大幅度減少標註成本,還可以解決不同圖像分割任務之間的遷移問題。因此,SAM模型在現代科技發展背景下代表著對圖像分割問題的一個重要突破和實用價值的開發。

|

| 圖1. 對CT影像使用SAM分析方框中的物體示意圖 |

從這個示範中(圖2),你可以看到這個模型可以接受像是點或框線之類的提示,然後輸出對應的物體面罩在指定的位置。 SAM已經學會了對於物體的一般概念 -- 這種理解能夠使其可以無需額外訓練就能夠泛化到不同的物體上。就好像SAM完全沒有看過我們的生日派對照片,卻能夠判斷出畫面中所有的物體,包含頭髮、口罩、衣物、鞋子、毛巾、螢幕、冷氣、電燈等等(圖3)

|

| 圖2. 使用框、點作為提示輸入,SAM切割出範圍內的物體(柯基犬) |

|

| 圖3. 高度泛化性的SAM將未看過的圖像進行物體切割 |

SAM訓練的概念來自自然語言處理(NLP),透過輸入給模型的提示:點、背景點、邊界框上的點、MASK,模型都能輸出有效的分割遮罩(MASK)。(圖4)

|

| 圖4. 透過輸入提示進行影像切割,同一個像素點被觸發都能生成不同種的有效遮罩。 |

這個訓練邏輯降低了影像成本,因為同一組圖片和遮罩答案能夠被使用多次,這有別於過往的影像視覺模型的訓練方法。

整個完整的模型主要有兩個編碼器和一個解碼器(圖5),首先會將圖片和提示進行編碼,再將其合併輸入給解碼器,解碼器會輸出對應圖片的遮罩。這訓練過程如上解釋,每一種提示輸入都會對應到至少一組有效的遮罩答案,這樣的訓練邏輯能讓SAM學習到物體的概念,這樣將能大幅提高模型泛化性,讓其可以對各種未曾看過的影像類型都能有相同的切割水準。

|

| 圖5. SAM的運作流程示意圖 |

現在各大巨頭公司皆埋首開發更強大的基礎模型,可預見通用人工智慧(Artificial General Intelligence-AGI)的出現已經指日可待。不論是去年中的生成式圖像模型或是去年底OpenAI推出的GPT-3 或是此篇主角SAM,都是各項領域的強大基礎模型,這些模型在人類的生活應用場景皆有很強大的泛化性,交互結合下可以誕生出更加符合複雜場景的需求。

未來也許不是AI取代人類,依舊是人類替代人類,在AI蓬勃方展的年代,知識就是力量正是最佳的形容,能掌握AI的人能夠提高幾倍工作效率,以及一個人無法了解所有領域知識,但我們能透過將AI做為導師學習各種領域的知識,大幅提高自己自身的能力。

撰文:許楷翊

參考文獻:

1. Meta官方介紹網址: https://segment-anything.com/

2. Segment anything : Kirillov, A., Mintun, E., Ravi, N., Mao, H., Rolland, C., Gustafson, L., ... & Girshick, R. (2023). Segment anything. arXiv preprint arXiv:2304.02643.

3. Segment anything GitHub: https://github.com/facebookresearch/segment-anything

留言

張貼留言