啟發式演算法與新類神經網路晶片帶來的新展望

之前我們聊過啟發式演算法的一員,研究中常用的演化演算法來進行未知的猜測學習,而今天我們就來講講這幾年因為硬體的高度發展而展露越來越強效果的啟發式演算法的展現吧。

相信大家對AlphaGo 強化學習訓練,最終打贏圍棋冠軍耳熟能詳,但不知道有沒有聽過2017年的Alpha Zero呢?這是DeepMind 交出的會「學習」的機械的新答案,Alpha Zero是通用的自我學習下棋AI,無論是西洋棋或是將棋這種非對稱的對弈棋盤也能得心應手,並且賴於啟發式演算法,使其完全無需人工標記特徵也無需事先學習任何人類棋譜,甚至無需任何特定調整就此最佳化的通用強化學習演算法 AlphaZero就此問世。

而近期AlphaZero作者Demis Hassabis與DeepMind的同事及Google Brain研究員合作研究,從AlphaZero神經網路找到人類下西洋棋概念的證據,顯示神經網路訓練過程獲得概念的時間和位置,還發現AlphaZero與人類不同風格之處[1],這對於真正可以自我學習的應用AI機器人更進一步,且將其拓展與昆士蘭科技大學和英特爾 Loihi 2 神經形態研究晶片的此項機器人感知世界的研究整合,或許就能使機器人能自我感知世界並可自我更新換代,自我疊代升級。

而類神經網路晶片的升級以及仿製人腦action potential方式的激發運算,將能使啟發式演算法此類運算量高需求的演算法更有可能帶上移動式機械人的設備上,還真是令人期待呢!

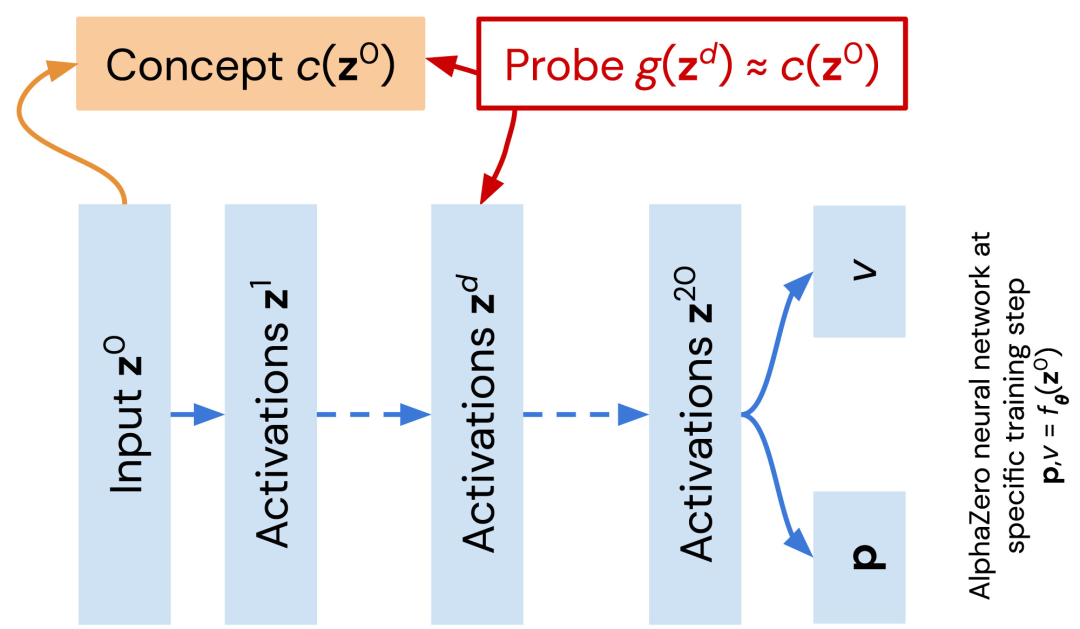

圖1為 AlphaZero網路(藍色)探索人類編碼的西洋棋概念。[1] 為了確定AlphaZero網路多大程度顯示人類下棋概念,將概念定義為圖1橘色所示用戶定義函數。當作探針,廣義線性函數g訓練用於近似西洋棋概念c。近似值g質量表示層(線性)對概念編碼的程度。給予概念,對每個網路所有層訓練過程產生的網路序列重複過程。[2]

|

| 圖1 |

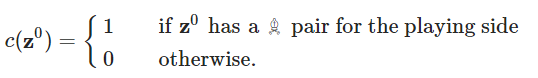

圖2 為一個例子,可用一個函數確定我或對手是否有「主教♗」(當然也還有更多更複雜的西洋棋概念,如棋子機動性(mobility))

|

| 圖2 |

圖3 為 what-when-where圖,可視化「計算概念是什麼」、「計算網路哪個位置發生」、「概念在網路訓練什麼時間出現」三指標。從A到B的概念分別是「總分評估」「我被將軍了嗎」「威脅評估」「我能吃掉對手的皇后嗎」「對手這步棋會將死我嗎」「子力分數評估」「子力分數」「我有士兵嗎」。[2] 隨著訓練越多,許多人類定義概念都可從AlphaZero表徵預測,且準確率很高。且多數what-when-where圖顯著特徵是網路回歸精確度在開始階段就增長迅速,之後達平穩或下降。代表從AlphaZero發現的概念集還只是檢測網路較早層,要了解後面層,需要新概念檢測技術。[2]

|

| 圖3 |

圖4A是人類對第一步棋偏好歷史演變,早期流行e4為第一步棋,後來開局策略更平衡靈活。而圖4B則是AlphaZero開局策略隨訓練演變。可看到AlphaZero開局總是平等權衡所有選擇,然後學習次數逐漸縮小範圍,最終傾向d4起手。而這樣的起因,作者猜測可能是因為人類西洋棋建立在歷史資料以及強大玩家的主觀集體意識,所以會導致起步統一,而後可能擴張,反之AlphaZero是自行從0學習,一路學習從初學者往上,才會有如此不同的反響。且研究中作者們發現,AlphaZero居然也會有想人一樣的開局起手偏好,而且不同版本訓練的AlphaZero偏好也不相同,最後作者總結,這項研究證明AlphaZero自我學習能重建許多人類西洋棋概念。且AlphaZero下棋風格與人類並不相同。既然我們以人類定義的西洋棋概念理解神經網路,那麼令人好奇的是:神經網路能學到人類知識以外的東西嗎?

|

| 圖4 AlphaZero開局策略與人類不同 |

撰文:徐楷昕

留言

張貼留言